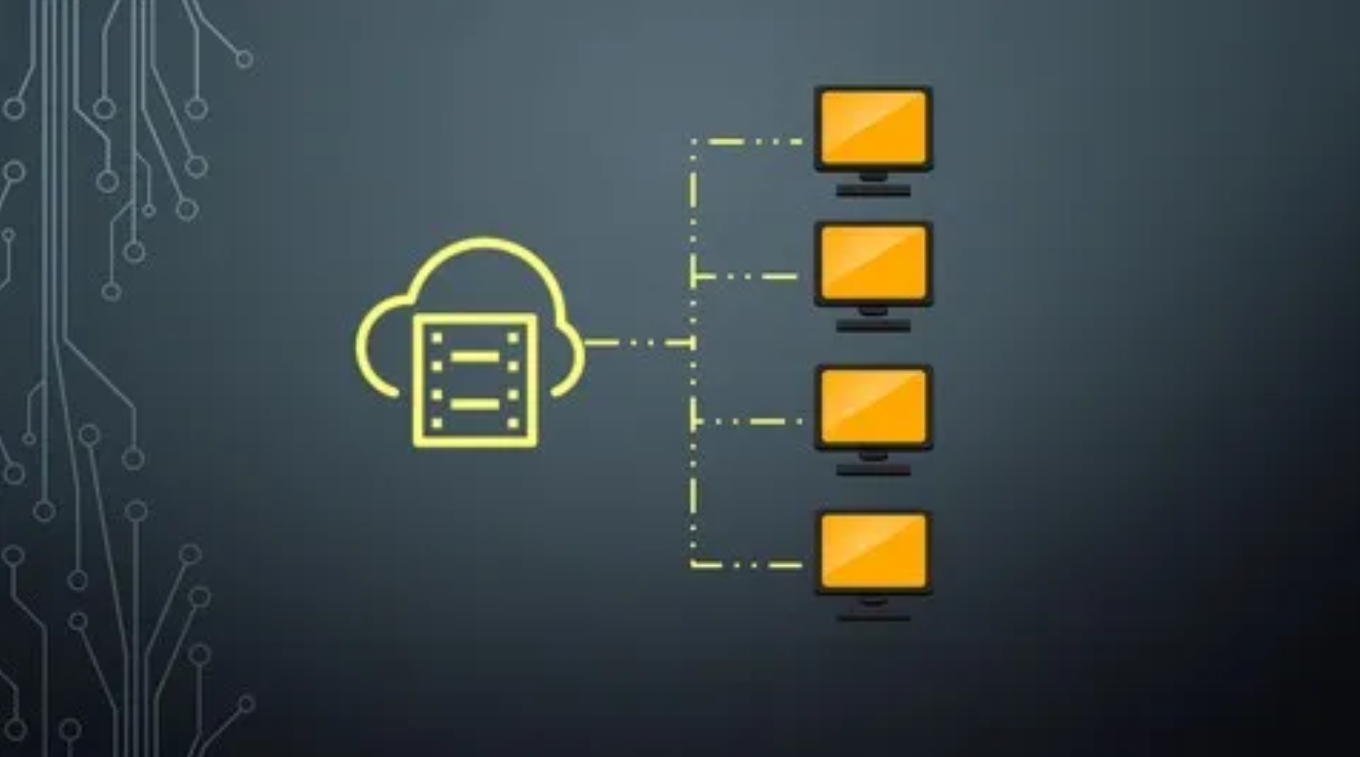

在大数据处理的领域中,Hadoop分布式文件系统(HDFS)扮演着举足轻重的角色。然而,在Linux环境下运行HDFS时,我们有时会遭遇节点缺失的问题,这一问题严重影响了数据的完整性和处理效率。

一、HDFS节点缺失的症状

当HDFS节点缺失时,最直接的表现是数据块的访问异常。用户可能会发现某些文件无法读取或写入,甚至整个集群的性能都会受到明显影响。通过HDFS的管理界面或命令行工具,我们可以观察到缺失节点的详细信息,包括其IP地址、所属机架以及缺失的具体原因。

二、 导致HDFS节点缺失的常见原因

-

硬件故障:硬盘损坏、网络中断或电源故障都可能导致HDFS节点无法正常工作。

-

软件问题:HDFS自身的bug、不兼容的软件版本或配置错误也可能引发节点缺失。

-

网络问题:网络延迟或配置错误会导致节点间通信不畅,进而影响节点的正常状态。

三、 解决HDFS节点缺失的策略

-

及时监控:通过HDFS自带的监控工具或第三方监控软件,实时掌握节点的状态,及时发现并处理异常。

-

**冗余备份:在HDFS中启用数据冗余策略,确保数据在多个节点上有备份,从而避免因单个节点故障导致的数据丢失。

-

故障排查与修复:一旦发现节点缺失,应立即进行故障排查,包括检查硬件状态、更新软件版本、调整网络配置等,以尽快恢复节点的正常工作。

![[linux_HDFS节点缺失问题及解析] [linux_HDFS节点缺失问题及解析]](https://img.doczz.cn/storage/20240414/61e9433775768da7ba04a545c5fbb54e.png)

总之,HDFS节点缺失是一个不容忽视的问题,只有深入分析问题根源,并采取有效的预防和解决措施,才能确保HDFS的稳定运行和数据的安全可靠。